Voice UI e interfacce conversazionali: se ne è parlato con Robert Schumacher ed Elisabetta Schiatti alla Ux Masterclass 2018 di Milano organizzata dalla UxAlliance e Assist Digital.

Dalle Graphical UI alle Voice UI

Le Voice UI sembrano essere the next big thing – insieme peraltro a molte tecnologie emergenti 😉 – nel mondo dell’interazione e della user experience. Sicuramente – dai tempi della metafora del desktop introdotta nel 1984 dalla Apple – le Voice UI, i chatbot, le interfacce conversazionali e gli altri modi di interazione vocale o dialogici con i device digitali stanno scardinando i paradigmi a cui le GUI ci avevano abituati.

Senza arrivare ai mondi distopici di 2001 Odissea nello spazio o di Her le interazioni vocali si stanno diffondendo sia come alternativa in contesti o per utenze particolari o in situazioni di intrattenimento.

Come ha sottolineato Luca Petroni di Assist Digital nell’intervento introduttivo, il 2007, con il lancio del primo iPhone, ha rappresentato il punto di svolta per molti fenomeni. Il settore mobile ha introdotto il concetto di interazione nomadica e, sopprattuto, human-like. La possibilità di parlare con i nostri device ha ampliato e potenziato il concetto di omnicanalità e reso, per certi aspetti e in certe situazioni, più fluida, rapida e efficiente la nostra relazione con il mondo circostante, fisico e virtuale.

Voice UI: dimenticatevi tutto quello che sapete sul design delle interfacce!

L’intervento di Robert Schumacher (@bobschu) smonta le certezze che possiamo avere accumulato in anni di professione e di esperienza sul design delle interfacce utente e sull’approccio mobile first nel momento in cui dobbiamo approcciare le voice UI. E dobbiamo farlo, perché sono qui per restare.

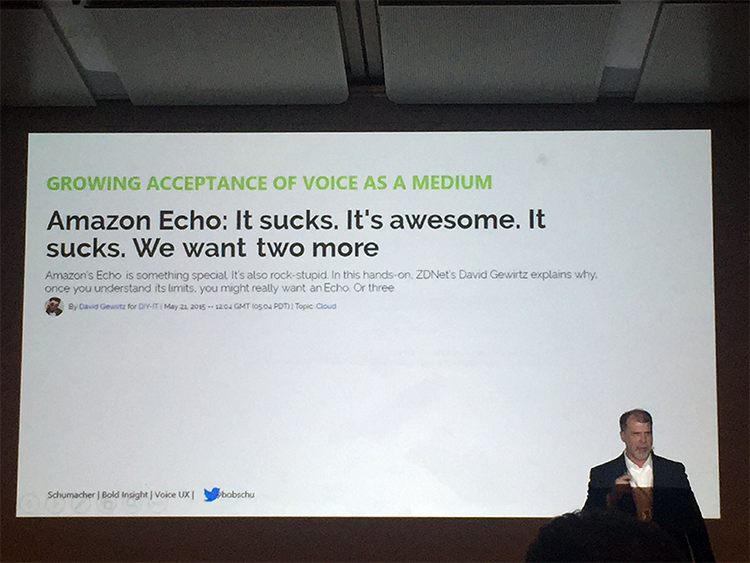

L’ambiguità di rapporto con questa nuova modalità di interazione – i primi esperimenti condotti da IBM risalgono al 1972 – è ben rappresentata da un tweet su Amazon Echo, uno dei dispositivi che permettono di interagire con Alexa, il personal assistan sviluppato, appunto, da Amazon.

Ma se parlare a un dispositivo può sembrare un’esperienza surreale, per il 40% dei millenials, sembra essere, invece, la modalità preferita. La percentuale è praticamente raddoppiata tra il 2016 e le previsioni 2019: dal 23,3% al 39,3% secondo le ricerche di eMarketer del 2017 riportate dal Schumacher.

Pro e contro

Le potenzialità delle voice UI come modalità di accesso o come agenti di facilitazione al mondo digitale dipendono, tuttavia, dal contesto di applicazione. Sono una buona soluzione per le persone totalmente o parzialmente analfabete (781 milioni di adulti di cui, il 67% donne!), per chi ha problemi visivi e per la popolazione anziana (over 65) che negli Stati Uniti rappresenta il 15% del totale.

Un secondo aspetto da considerare è la differenza pratica, cognitiva e percepita tra la modalità testuale (occhi e dita) e la modalità vocale (orecchie e voce) di interazione. L’ascolto è più rapido con una velocità media di 210 parole a minuto contro le 180 della lettura, così come il parlato rispetto alla scrittura (150 pam vs. 35/30 a seconda della tastiera).

Se parlare ci evita i tipici errori di battitura il rumore dell’ambiente circostante può rappresentare un grosso limite all’uso delle interfacce vocali. La sequenzialità del parlato, rispetto alla possibilità di comprendere a colpo d’occhio un insieme di informazioni, è un ulteriore fattore negativo, così come la complessiva mancanza di privacy.

La variabile umana

Una questione che rimane, al momento, ancora aperta è la capacità delle macchine – e talvolta delle altre persone – di comprendere una conversazione nella complessità e nelle sfumature tipiche dell’operatore umano. Che si tratti della vaghezza di tipo semantico, dell’omofonia/omonimia o semplicemente dell’ambiguità del linguaggio naturale, la ricchezza verbale nelle sue sfumature di senso, di intonazione di struttura e nelle sue regole implicite sembrano ancora troppo anche per l’intelligenza artificiale.

Le euristiche delle Voice UI

Tra i suggerimenti che Schumacher condivide, ci sono anche i cambiamenti di paradigma che Ux e UI designer devono affrontare nella loro pratica progettuale come le euristiche e i deliverables:

- Multimodalità dell’interazione1

- Aspettative e anticipazione delle risposte

- Prevenzione degli errori

- Mantenere la logica conversazionale

- Rispettare le caratteristiche del linguaggio nel suo ritmo e intonazioni

- Dare libertà e controllo agli utenti

- Flessibilità ed efficienza d’uso

- Gestire le limitazioni utilizzando anche altri media/canali

Ed infine, progettare l’esperienza conversazionale significa abbandonare il concetto di screen flow e di wireframe in favore di un dialog flow che rappresenti le caratteristiche e i flussi di una interazione vocale.

Come progettare le interfacce conversazionali?

Un secondo intervento sul tema è stato quello di Elisabetta Schiatti (@lisa_dubh) – più orientato sui principi e gli aspetti operativi del design. E. propone subito una distinzione tra quelle basate sulla voce – come Siri, Cortana, Alexa, Google Assitant e Hound – e quelle basate su messaggistica – come FBchat, Skype, WeChat, Kik, Telegram o tutte quelle app che adottano lo stile di interazione a chat.

Le voice UI, in particolare, risultano essere location-specific e orientate alla richiesta di esecuzione di task dal punto di vista dell’applicazione, ma soprattutto suscitano negli utenti la necessità non solo del riconoscimento (recognition) dei suoni, ma di comprensione (understanding), se non, addirittuta, di una capacità conversazionale emozionale. Più la risposta tecnologica sembra umana, più le persone tendono a interpretare questa attitudine come reale.

Riconoscimento

Al di là della accuratezza dello speech recognition – che nei sistemi Google ha raggiunto in condizioni ideali il 92% – le difficoltà tecnologiche dipendono prevalentemente dal contesto e da alcune peculiarità degli interlocutori.

Le condizioni che mettono in difficoltà sono, per esempio:

- i rumori di fondo e ambientali

- la presenza di più persone che partecipano alla conversazione

- il modo di parlare dei bambini

- le frasi troppo corte/cortissime

- i nomi, lo spelling e le stringhe alfanumeriche (come la lettura di una targa)

- tono, intonazione e punteggiatura

Comprensione

Il piano della compresione si gioca, ovviamente, su aspetti più sfumati e inerenti al ritmo naturale delle conversazioni umane: non un semplice botta e risposta o un parlare a turno, bensì una forma dialogica complessa. Inoltre, le persone, nel loro parlare, sonoin grado di tenere presente anche quanto è già stato detto e quindi di utilizzare lo storico come un elemento di contesto e di conoscenza.

Linee guida di progetto delle voice UI/chatbot

Andare oltre il turno: ovvero cercare di mantenere traccia del dialogo passato e delle coreferenze per rendere l’esperienza più simile al dialogo umano malgrado le difficoltà tecniche.

Gestire l’ascolto: come in una conversazione, le pause possono comunicare che si è finito di parlare (end-point detection) o che sono necessarie più informazioni, che c’è un’esitazione o che ci si può inserire o meno, nel parlato (barge-in). Aspetti questi che devono essere progettati sia lato bot che lato user in modo che il primo capisca e non perda informazioni e che il secondo abbia l’impressione di essere ascoltato.

Usare i conversational marker: come quelli di apertura e chiusura come i saluti, quelli di attestazione – graze, va bene, mi spiace – quelli temporali – prima, dopo, infine – i feed-back positivi come “ben detto!” e, infine, quelli di transizione (dunque, quindi, allora)

Creare una personalità: un tono di voce, più palese nelle voice UI, che sia da un lato, coerente con il brand e, dall’altro, garantisca una dimensione più umana all’esperienza.

Strategia di conferma: che può essere esplicita (risposta alla domanda), implicita (ripetizione con richiesta di conferma) o generica, ma anche multimodale. Dove può essere utile, infatti, posso ricorrere ad altri canali di comunicazione o fare ricorso alle GUI per veicolare anche messaggi visivi.

Risposta a domande difficili: sia ricorrendo ai motori di ricerca, ma soprattutto gestendo situaizoni come richieste multiple o negazioni, che escono dallo schema botta e risposta.

Sapere riparare le conversazioni in una dimensione cooperativa dell’interazione, tutte le volte che è necessario reinquadrare o ricontestualizzare il dialogo.

Ed infine, ma non ultimo per priorità, sapere scegliere quando è opportuno e come usare una voice UI!

Per approfondire:

- Ux Masterclass 2018, Milano

- UXalliance

- Assist Digital

- Robert Schumacher alla Ux Masterclass

- Schumacher, R. (2018, Febrauary 14th). Designing for Voice: The next phase of UX design

- Elisabetta Schiatti alla Ux Masterclass

- per appronfondire potete leggere: Registica multimodale 😉 ↩